Koeling voor GPU-clusters: Lucht vs Vloeistof vs Immersion — Reële cijfers

In 2026 vormen GPU-clusters de kern van AI-training, wetenschappelijke modellering en grootschalige data-analyse. Een enkel rack met acht NVIDIA H100- of vergelijkbare accelerators kan gemakkelijk meer dan 10–12 kW verbruiken, terwijl dense AI-racks steeds vaker 80–120 kW overschrijden. Bij dit vermogensniveau is koeling geen secundair technisch detail meer, maar een fundamentele ontwerpkeuze. De selectie tussen geavanceerde luchtkoeling, direct-to-chip vloeistofkoeling en volledige immersion-systemen beïnvloedt investeringskosten, operationele uitgaven, energie-efficiëntie en langetermijnbetrouwbaarheid. Dit artikel vergelijkt de drie dominante benaderingen op basis van actuele marktgegevens uit 2026.

Geavanceerde luchtkoeling: de grenzen van traditioneel datacenterontwerp

Luchtkoeling blijft de meest toegepaste methode in bestaande datacenters. Moderne faciliteiten maken gebruik van hot aisle- of cold aisle-containment, krachtige ventilatoren en rear-door heat exchangers. In 2026 ondersteunt een geoptimaliseerd luchtgekoeld rack doorgaans 20–30 kW zonder ingrijpende aanpassingen. Met verfijnd luchtbeheer en in-row koeling kan men 40–50 kW per rack bereiken, maar dit benadert de praktische limiet van standaard raised-floor omgevingen.

Wat efficiëntie betreft, ligt de Power Usage Effectiveness (PUE) in AI-gerichte datacenters met luchtkoeling meestal tussen 1,3 en 1,6, afhankelijk van klimaat en de inzet van vrije koeling. Het energieverbruik van ventilatoren kan 5–10% van de totale IT-belasting vertegenwoordigen in dichte GPU-opstellingen. Wanneer rackdichtheid boven 40 kW stijgt, nemen luchtvolumes disproportioneel toe, wat leidt tot hogere geluidsniveaus, mechanische belasting en ongelijkmatige warmteverdeling.

De initiële investeringskosten lijken lager, vooral wanneer bestaande infrastructuur wordt hergebruikt. Toch vereist het aanpassen van een faciliteit voor racks boven 40 kW vaak versterkte stroomvoorziening, nieuwe CRAC-units en containmentstructuren. Door lagere vermogensdichtheid is bovendien meer vloeroppervlak nodig, waardoor de totale kosten per kW minder aantrekkelijk kunnen worden bij grootschalige AI-projecten.

Wanneer luchtkoeling nog steeds logisch is

Luchtkoeling blijft geschikt voor edge AI-clusters, onderzoeksomgevingen en middelgrote trainingsinfrastructuren waar rackdichtheid onder 25–30 kW blijft. In dergelijke scenario’s wegen snelle implementatie en compatibiliteit met bestaande zalen vaak zwaarder dan maximale efficiëntie.

In koelere regio’s kan vrije luchtkoeling de operationele kosten aanzienlijk verlagen. Datacenters in Noord-Europa kunnen een groot deel van het jaar buitenlucht benutten, waardoor de koelenergie met 20–30% kan dalen in vergelijking met warmere gebieden.

Een bijkomend voordeel is operationele vertrouwdheid. De meeste technici zijn opgeleid in HVAC-systemen en luchtstroomoptimalisatie. Er is geen nood aan lekdetectie, koelvloeistofanalyse of gespecialiseerde leidingsystemen, wat onderhoud eenvoudiger maakt.

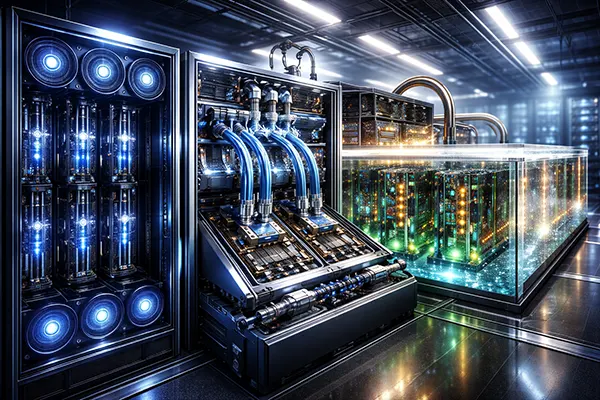

Direct-to-chip vloeistofkoeling: efficiëntie bij hoge dichtheid

Direct-to-chip vloeistofkoeling (DLC) is in 2026 de voorkeursoplossing voor hoge-dichtheid AI-clusters. Hierbij worden cold plates rechtstreeks op GPU’s en CPU’s gemonteerd, die warmte afvoeren via een gesloten water- of water-glycollus. Moderne DLC-opstellingen ondersteunen probleemloos 60–100 kW per rack, terwijl gespecialiseerde ontwerpen 120 kW of meer bereiken.

Vloeistof heeft per volume-eenheid een warmtecapaciteit die duizenden keren hoger ligt dan lucht, wat veel efficiënter warmte transport mogelijk maakt. Daardoor behalen DLC-faciliteiten vaak PUE-waarden tussen 1,1 en 1,25. Ventilatoren draaien op lagere snelheid of worden deels geëlimineerd, waardoor het koelenergieverbruik onder 5% van de IT-belasting kan dalen.

De investeringskosten zijn hoger dan bij luchtkoeling. Cold plates, manifolds, CDU’s en lekdetectiesystemen verhogen het budget met circa £700–£1.200 per kW boven standaard luchtopstellingen. Toch compenseren energiebesparing en hogere rackdichtheid deze meerkosten meestal binnen drie tot vijf jaar bij continu belaste AI-workloads.

Operationele realiteit van vloeistofsystemen

Betrouwbaarheidsgegevens van hyperscale-operators tonen aan dat moderne quick-disconnect koppelingen het aantal lekkages hebben teruggebracht tot minder dan 0,1% per jaar over grote installaties. Correcte inbedrijfstelling en druktesten blijven cruciaal.

De aanvoertemperatuur van water ligt doorgaans tussen 25–35°C, met retourtemperaturen tot 45–50°C. Deze hogere retourtemperatuur maakt warmteterugwinning voor stadsverwarming of industriële processen economisch aantrekkelijk.

Het onderhoud is complexer dan bij luchtkoeling. Koelvloeistofkwaliteit moet worden bewaakt om corrosie en vervuiling te voorkomen. Toch heeft DLC zich in 2026 gevestigd als standaard voor nieuwe AI-georiënteerde datacenters in Europa, Noord-Amerika en delen van Azië.

Immersion-koeling: maximale dichtheid en thermische stabiliteit

Immersion-koeling dompelt servers volledig onder in een diëlektrische vloeistof, waardoor traditionele luchtcirculatie overbodig wordt. In 2026 ondersteunen single-phase systemen doorgaans meer dan 100 kW per rack-equivalent, terwijl two-phase oplossingen 150 kW of meer kunnen bereiken in gespecialiseerde omgevingen.

De energie-efficiëntie is bijzonder hoog. Correct ontworpen immersion-faciliteiten behalen PUE-waarden tussen 1,05 en 1,15. Omdat serverventilatoren verdwijnen, kan het elektrische verbruik met 10–15% dalen. Gelijkmatige koeling vermindert bovendien thermische throttling, wat stabielere prestaties oplevert bij langdurige AI-training.

Daartegenover staan hogere initiële kosten en aangepaste operationele processen. Diëlektrische vloeistoffen zijn kostbaar en tankgebaseerde infrastructuur wijkt sterk af van traditionele racks. Hardwarecompatibiliteit moet vooraf worden gevalideerd, hoewel ondersteuning door fabrikanten in 2026 duidelijk is toegenomen.

Praktische afwegingen bij immersion-systemen

Vloeistofbeheer is essentieel voor langdurige stabiliteit. Exploitanten moeten contaminatie monitoren en filtratiecycli uitvoeren om prestaties te behouden. Moderne vloeistoffen zijn stabiel en niet-geleidend, maar vereisen strikte procedures.

Servicewerkzaamheden verschillen aanzienlijk van conventionele racks. Het verwijderen van een server uit een tank vereist aangepaste veiligheidsmaatregelen en procedures, wat training noodzakelijk maakt.

Immersion toont zijn sterkste economische waarde in ultra-dense AI-clusters waar ruimte schaars en elektriciteit duur is. In colocatie- of retrofitprojecten kunnen fysieke beperkingen de implementatie bemoeilijken, ondanks de uitstekende efficiëntiecijfers.