Raffreddamento per cluster GPU: aria vs liquido vs immersione — dati reali

Nel 2026 i cluster GPU sono diventati la base dell’addestramento AI, della modellazione scientifica e dell’analisi dati su larga scala. Un singolo rack con otto NVIDIA H100 o acceleratori equivalenti può superare facilmente i 10–12 kW, mentre i rack AI ad alta densità raggiungono sempre più spesso 80–120 kW. A questi livelli di potenza, il raffreddamento non è più un dettaglio tecnico secondario, ma un vincolo progettuale centrale. La scelta tra raffreddamento ad aria avanzato, liquido direct-to-chip e sistemi a immersione totale influisce direttamente su costi di investimento, spese operative, efficienza energetica e affidabilità a lungo termine. Questo articolo analizza i tre approcci principali utilizzando dati aggiornati e casi reali di implementazione.

Raffreddamento ad aria avanzato: i limiti del design tradizionale

Il raffreddamento ad aria resta il metodo più diffuso nei data centre esistenti. Le strutture moderne ad alte prestazioni utilizzano contenimento dei corridoi caldo/freddo, ventilatori ad alta pressione statica e scambiatori di calore posteriori. Nel 2026 un rack ben ottimizzato con raffreddamento ad aria supporta in genere 20–30 kW senza modifiche strutturali importanti. Con gestione avanzata dei flussi e sistemi in-row si possono raggiungere 40–50 kW per rack, ma questo rappresenta il limite pratico per ambienti tradizionali con pavimento sopraelevato.

Dal punto di vista dell’efficienza, i sistemi ad aria comportano solitamente un PUE compreso tra 1,3 e 1,6 nei data centre orientati all’AI, a seconda del clima e dell’uso del free cooling. Il consumo dei ventilatori può rappresentare da solo il 5–10% del carico IT totale nei cluster GPU ad alta densità. Oltre i 40 kW per rack, le esigenze di flusso d’aria crescono in modo non lineare, con aumento del rumore, maggiore stress meccanico e distribuzione termica meno uniforme.

I costi iniziali del raffreddamento ad aria possono sembrare inferiori, soprattutto quando si riutilizzano infrastrutture esistenti. Tuttavia, l’adeguamento di una struttura per supportare rack oltre i 40 kW richiede spesso nuovi impianti di climatizzazione, potenziamento dell’alimentazione e sistemi di contenimento. Considerando anche la minore densità per metro quadro, il costo complessivo per kW può risultare meno competitivo nei progetti AI su larga scala.

Quando il raffreddamento ad aria è ancora adatto

Il raffreddamento ad aria resta una scelta valida per cluster AI edge, laboratori di ricerca e ambienti di addestramento di medie dimensioni dove la densità non supera 25–30 kW per rack. In questi contesti, la rapidità di implementazione e la compatibilità con infrastrutture esistenti possono essere determinanti.

Nei paesi con clima freddo, il free cooling ad aria esterna consente una riduzione significativa dei costi operativi. In Europa settentrionale, ad esempio, è possibile sfruttare l’aria esterna per gran parte dell’anno, riducendo l’energia necessaria al raffreddamento del 20–30% rispetto a regioni più calde.

Un ulteriore vantaggio è la familiarità operativa. Il personale tecnico dei data centre è generalmente formato per la gestione dei sistemi HVAC tradizionali. Non sono richiesti circuiti idraulici complessi né monitoraggio continuo di fluidi refrigeranti, semplificando le procedure di manutenzione.

Raffreddamento a liquido direct-to-chip: efficienza ad alta densità

Il raffreddamento a liquido direct-to-chip (DLC) è diventato nel 2026 la soluzione predominante per cluster AI ad alta densità. In questa configurazione, piastre fredde sono montate direttamente su GPU e CPU, rimuovendo il calore tramite un circuito chiuso ad acqua o acqua-glicole. I sistemi moderni supportano agevolmente densità di 60–100 kW per rack, con progetti specializzati che superano i 120 kW.

L’acqua ha una capacità termica volumetrica circa 3.500 volte superiore a quella dell’aria, consentendo un trasferimento di calore molto più efficiente. I data centre con DLC raggiungono spesso valori di PUE tra 1,1 e 1,25 in condizioni ottimizzate. L’uso dei ventilatori si riduce drasticamente e l’energia dedicata al raffreddamento può scendere sotto il 5% del carico IT totale.

Dal punto di vista economico, il DLC richiede un investimento iniziale maggiore. Piastre fredde, CDU (Coolant Distribution Unit), collettori e sistemi di rilevamento perdite aumentano il CAPEX. Nel 2026 il costo aggiuntivo è stimato tra 700 e 1.200 sterline per kW rispetto a un impianto tradizionale ad aria. Tuttavia, nei carichi AI ad utilizzo costante, il ritorno dell’investimento può realizzarsi in 3–5 anni grazie a risparmi energetici e maggiore densità.

Considerazioni operative sul raffreddamento a liquido

I dati dei grandi operatori indicano che i moderni connettori a sgancio rapido e i circuiti sigillati hanno ridotto le perdite a meno dello 0,1% annuo su larga scala. Test di pressione e corretta messa in servizio restano fondamentali per garantire affidabilità.

Le temperature di mandata nei sistemi DLC si collocano tipicamente tra 25 e 35°C, mentre il ritorno può raggiungere 45–50°C. Questo consente il recupero del calore per teleriscaldamento o processi industriali, migliorando l’efficienza complessiva del sito.

La gestione richiede monitoraggio della qualità del liquido, prevenzione della corrosione e ridondanza delle pompe. Nonostante ciò, per nuovi data centre AI in Europa e Nord America, il DLC rappresenta ormai lo standard di riferimento.

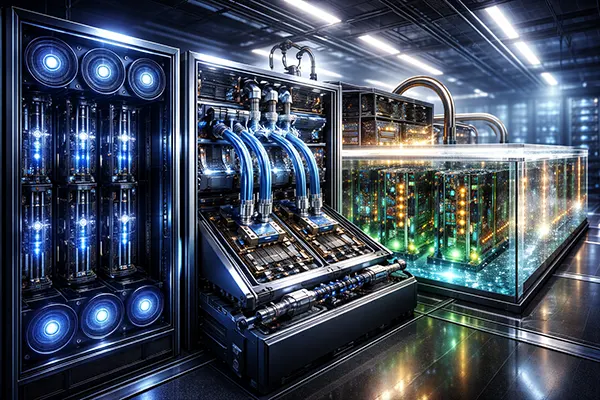

Raffreddamento a immersione: massima densità e stabilità termica

Il raffreddamento a immersione prevede l’immersione completa dei server in un fluido dielettrico. Nel 2026 i sistemi monofase supportano densità equivalenti superiori a 100 kW per rack, mentre le soluzioni bifase possono superare i 150 kW in contesti specializzati. L’uniformità termica è superiore, poiché tutti i componenti vengono raffreddati in modo omogeneo.

L’efficienza energetica è uno dei principali vantaggi. Un impianto a immersione ben progettato può raggiungere valori di PUE tra 1,05 e 1,15. L’assenza di ventilatori server riduce il consumo elettrico del 10–15% a livello di singolo nodo. Inoltre, la stabilità termica limita il throttling e può migliorare le prestazioni sostenute delle GPU nei carichi AI intensivi.

Tuttavia, l’immersione comporta costi iniziali più elevati e adattamenti operativi significativi. I fluidi dielettrici sono costosi e l’infrastruttura a vasca differisce dai rack tradizionali. Non tutti i produttori certificano ufficialmente questo tipo di implementazione, anche se nel 2026 il supporto è in crescita.

Compromessi pratici dei sistemi a immersione

La gestione del fluido è essenziale per la stabilità a lungo termine. Occorre monitorare contaminazione e qualità, filtrando o sostituendo periodicamente il liquido. I fluidi moderni sono stabili e non conduttivi, ma richiedono procedure rigorose.

Le operazioni di manutenzione differiscono dai rack convenzionali. L’estrazione di un server da una vasca richiede procedure specifiche e dispositivi di protezione. Con formazione adeguata, questi aspetti diventano gestibili, ma restano meno intuitivi rispetto ai sistemi ad aria.

L’immersione offre il miglior rapporto costo/beneficio in cluster AI ad altissima densità, soprattutto dove lo spazio è limitato e il costo dell’energia è elevato. Nei progetti di retrofit o in ambienti di colocation, i vincoli strutturali possono limitarne l’applicazione nonostante le elevate prestazioni energetiche.