Refroidissement des clusters GPU : air vs liquide vs immersion — chiffres réels

En 2026, les clusters GPU constituent l’infrastructure centrale de l’entraînement des modèles d’IA, de la simulation scientifique et de l’analyse massive de données. Un seul rack équipé de huit accélérateurs NVIDIA H100 ou équivalents peut dépasser 10 à 12 kW, tandis que les racks IA haute densité franchissent désormais les 80 à 120 kW. À ces niveaux de puissance, le refroidissement devient un facteur stratégique. Le choix entre refroidissement par air avancé, refroidissement liquide direct sur puce et immersion complète influence directement les coûts d’investissement, les dépenses énergétiques, l’efficacité globale et la fiabilité à long terme. Cet article examine ces trois approches à partir de données concrètes et actuelles pour 2026.

Refroidissement par air avancé : les limites des centres de données traditionnels

Le refroidissement par air reste la solution la plus répandue dans les centres de données existants. Les installations modernes utilisent le confinement d’allées chaudes ou froides, des ventilateurs à haute pression statique et des échangeurs thermiques en porte arrière. En 2026, un rack bien optimisé refroidi par air supporte généralement entre 20 et 30 kW sans modification majeure. Avec une gestion d’air poussée et un refroidissement en rangée, certaines infrastructures atteignent 40 à 50 kW, mais cela représente une limite pratique pour les environnements classiques à plancher technique.

Du point de vue énergétique, les centres de données refroidis par air affichent en général un PUE compris entre 1,3 et 1,6 pour des charges IA denses, selon le climat et l’usage du free cooling. La consommation des ventilateurs peut représenter 5 à 10 % de la charge IT totale dans les environnements GPU intensifs. Au-delà de 40 kW par rack, les besoins en débit d’air augmentent fortement, ce qui accroît le bruit, la contrainte mécanique et les risques de déséquilibre thermique.

Les coûts initiaux semblent plus faibles lorsque l’on exploite une infrastructure existante. Toutefois, adapter un site pour des racks de plus de 40 kW implique souvent un renforcement de l’alimentation électrique, l’ajout d’unités CRAC et des systèmes de confinement. En tenant compte de l’espace au sol nécessaire — plus important à densité réduite — le coût global par kW devient moins compétitif pour les déploiements IA à grande échelle.

Dans quels cas l’air reste pertinent

Le refroidissement par air demeure adapté aux clusters IA de taille moyenne, aux laboratoires de recherche ou aux environnements edge où la densité ne dépasse pas 25 à 30 kW par rack. Dans ces contextes, la rapidité de déploiement et la compatibilité avec l’existant peuvent l’emporter sur les gains d’efficacité des solutions liquides.

Dans les régions au climat frais, le free cooling permet de réduire sensiblement les coûts d’exploitation. En Europe du Nord, par exemple, l’utilisation prolongée de l’air extérieur peut diminuer la consommation liée au refroidissement de 20 à 30 % par rapport aux zones plus chaudes.

La maintenance constitue également un avantage. Les équipes techniques sont généralement formées aux systèmes HVAC traditionnels, sans nécessité de gérer des circuits hydrauliques complexes ou des dispositifs avancés de détection de fuites.

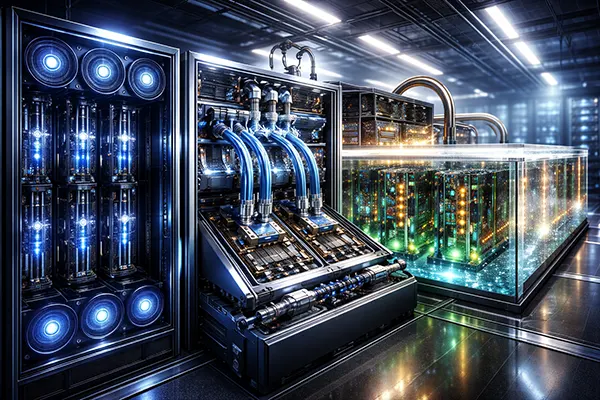

Refroidissement liquide direct sur puce : efficacité à haute densité

Le refroidissement liquide direct sur puce (DLC) s’est imposé en 2026 comme la solution privilégiée pour les clusters IA à forte densité. Des plaques froides sont fixées directement sur les GPU et CPU, évacuant la chaleur via un circuit fermé à base d’eau ou d’eau glycolée. Les racks équipés de DLC fonctionnent couramment entre 60 et 100 kW, certains déploiements spécialisés dépassant 120 kW par rack.

Le liquide possède une capacité thermique volumique très supérieure à celle de l’air, ce qui permet un transport de chaleur nettement plus efficace. Les centres de données utilisant le DLC atteignent fréquemment un PUE compris entre 1,1 et 1,25. La vitesse des ventilateurs internes diminue, voire leur présence devient partielle, ce qui réduit la consommation électrique associée au refroidissement en dessous de 5 % de la charge IT totale dans des installations optimisées.

L’investissement initial est plus élevé. Les plaques froides, les collecteurs, les unités de distribution de liquide (CDU) et les systèmes de sécurité ajoutent un surcoût estimé en 2026 entre 700 et 1 200 £ par kW par rapport à une infrastructure classique à air. Toutefois, la densité accrue et les économies d’énergie compensent souvent cet écart sur un cycle de vie de trois à cinq ans dans les environnements IA intensifs.

Réalités opérationnelles du refroidissement liquide

Les données issues des grands opérateurs montrent que les systèmes modernes à connexions rapides affichent un taux d’incident extrêmement faible, inférieur à 0,1 % par an sur des flottes étendues. Des tests de pression et une mise en service rigoureuse restent essentiels.

Les températures d’alimentation se situent généralement entre 25 et 35 °C, avec un retour pouvant atteindre 45 à 50 °C. Ces températures élevées facilitent la valorisation de la chaleur pour le chauffage urbain ou des usages industriels.

La maintenance exige un suivi de la qualité du fluide, la prévention de la corrosion et la gestion de la redondance des pompes. Malgré cette complexité accrue, le DLC est devenu la référence pour les nouveaux centres de données orientés IA en Europe et en Amérique du Nord.

Refroidissement par immersion : densité maximale et stabilité thermique

Le refroidissement par immersion consiste à plonger entièrement les serveurs dans un fluide diélectrique. En 2026, les systèmes à immersion monophasique supportent couramment plus de 100 kW par équivalent rack, tandis que les solutions biphasées peuvent dépasser 150 kW dans des environnements spécialisés. L’uniformité thermique est nettement améliorée, les composants étant refroidis sur toutes leurs faces.

L’efficacité énergétique constitue un atout majeur. Les installations correctement conçues atteignent un PUE entre 1,05 et 1,15. L’absence de ventilateurs internes permet une économie électrique de 10 à 15 % au niveau des serveurs. La réduction des points chauds limite également le throttling thermique, améliorant la performance soutenue des GPU sous forte charge.

Les coûts initiaux sont supérieurs à ceux des solutions à air et comparables, voire légèrement plus élevés, que le DLC. Les fluides diélectriques représentent un investissement significatif et l’architecture en cuves diffère radicalement des racks traditionnels. La compatibilité matérielle s’est toutefois améliorée en 2026, avec davantage de constructeurs validant officiellement cette approche.

Compromis pratiques des systèmes par immersion

La gestion du fluide est déterminante pour la stabilité à long terme. Les opérateurs doivent surveiller la contamination et assurer une filtration régulière afin de préserver les performances thermiques.

Les procédures de maintenance diffèrent des environnements classiques. Le retrait d’un serveur nécessite un protocole spécifique et un équipement adapté, ce qui demande une formation ciblée des équipes techniques.

L’immersion présente son avantage économique principal dans les clusters IA ultra-denses où l’espace est limité et le coût de l’électricité élevé. Dans des contextes de colocation ou de modernisation partielle, les contraintes physiques peuvent en limiter l’adoption malgré ses excellents indicateurs d’efficacité.