Kühlung für GPU-Cluster: Luft vs. Flüssigkeit vs. Immersion — Reale Zahlen

Im Jahr 2026 bilden GPU-Cluster das Rückgrat von KI-Training, wissenschaftlicher Simulation und gross angelegter Datenanalyse. Ein einzelnes Rack mit acht NVIDIA H100 oder vergleichbaren Beschleunigern kann deutlich über 10–12 kW aufnehmen, während dicht gepackte KI-Racks zunehmend 80–120 kW überschreiten. Bei diesen Leistungswerten ist Kühlung kein Nebenthema mehr, sondern eine zentrale technische Herausforderung. Die Entscheidung zwischen moderner Luftkühlung, Direct-to-Chip-Flüssigkeitskühlung und vollständiger Immersion beeinflusst Investitionskosten, Betriebsausgaben, Energieeffizienz und langfristige Zuverlässigkeit erheblich. Dieser Beitrag vergleicht die drei führenden Ansätze anhand aktueller Branchenkennzahlen aus dem Jahr 2026.

Moderne Luftkühlung: Grenzen klassischer Rechenzentrumsarchitektur

Luftkühlung ist weiterhin die am weitesten verbreitete Methode in bestehenden Rechenzentren. Leistungsfähige Anlagen setzen auf Warm- oder Kaltgangeinhausung, Hochdrucklüfter und Rear-Door-Wärmetauscher. Im Jahr 2026 unterstützt ein optimiertes luftgekühltes Rack typischerweise 20–30 kW ohne grundlegende Umbauten. Mit konsequenter Luftstromführung und In-Row-Kühlung lassen sich vereinzelt 40–50 kW pro Rack erreichen, doch dies gilt bereits als praktisches Limit für klassische Raised-Floor-Umgebungen.

In Bezug auf die Effizienz liegt der PUE-Wert (Power Usage Effectiveness) bei KI-orientierten Hallen meist zwischen 1,3 und 1,6, abhängig von Klima und Freikühlungsanteil. Allein der Energiebedarf der Lüfter kann 5–10 % der gesamten IT-Last ausmachen. Steigt die Leistungsdichte über 40 kW pro Rack, wächst der Luftbedarf überproportional, was zu höherer Geräuschentwicklung, mechanischer Belastung und ungleichmässiger Temperaturverteilung führt.

Auf den ersten Blick wirkt Luftkühlung kostengünstiger, insbesondere wenn bestehende Infrastruktur weiter genutzt wird. Doch die Nachrüstung für 40-kW+-Racks erfordert häufig neue Klimageräte, verstärkte Stromverteilung und Einhausungssysteme. Hinzu kommt die geringere Flächeneffizienz: Niedrigere Leistungsdichte bedeutet mehr Racks und damit höhere Bau- und Betriebskosten pro kW.

Wann Luftkühlung weiterhin sinnvoll ist

Für Edge-KI-Cluster, Forschungseinrichtungen oder mittelgrosse Trainingsumgebungen mit maximal 25–30 kW pro Rack bleibt Luftkühlung praktikabel. In solchen Szenarien überwiegen schnelle Implementierung und Kompatibilität mit vorhandenen Hallen die Effizienzvorteile flüssigkeitsbasierter Systeme.

In kühleren Regionen Europas ermöglicht Freikühlung über weite Teile des Jahres eine deutliche Senkung der Betriebskosten. Je nach Standort kann der zusätzliche Energieaufwand für Kühlung um 20–30 % reduziert werden.

Ein weiterer Vorteil liegt in der betrieblichen Routine. Das technische Personal ist mit HVAC-Systemen vertraut, und es sind keine speziellen Kenntnisse in Bezug auf Kühlmittelmanagement oder Lecküberwachung erforderlich.

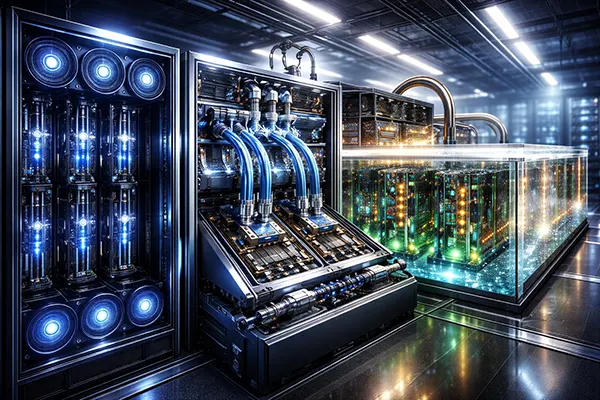

Direct-to-Chip-Flüssigkeitskühlung: Effizienz bei hoher Leistungsdichte

Direct-to-Chip-Flüssigkeitskühlung (DLC) hat sich 2026 als bevorzugte Lösung für hochdichte KI-Cluster etabliert. Dabei werden Kühlplatten direkt auf GPUs und CPUs montiert, um Wärme über einen geschlossenen Wasser- oder Wasser-Glykol-Kreislauf abzuführen. Moderne DLC-Systeme unterstützen problemlos 60–100 kW pro Rack, spezialisierte Installationen überschreiten sogar 120 kW.

Flüssigkeit besitzt eine rund 3.500-fach höhere volumetrische Wärmekapazität als Luft, was einen deutlich effizienteren Wärmetransport ermöglicht. Rechenzentren mit DLC erreichen typischerweise PUE-Werte zwischen 1,1 und 1,25. Der Bedarf an Serverlüftern sinkt erheblich, was den Kühlenergieanteil teilweise auf unter 5 % der IT-Last reduziert.

Die Investitionskosten sind höher als bei Luftkühlung. Kühlplatten, Verteilereinheiten (CDU) und Überwachungssysteme erhöhen die Anfangsinvestition um etwa 700–1.200 £ pro kW im Vergleich zu Standardlösungen. Über einen Zeitraum von drei bis fünf Jahren gleichen jedoch Energieeinsparungen und höhere Rack-Dichte diese Mehrkosten häufig aus, insbesondere bei kontinuierlich ausgelasteten KI-Trainingsclustern.

Betriebliche Aspekte der Flüssigkeitskühlung

Erfahrungen grosser Betreiber zeigen, dass moderne Schnellkupplungen und geschlossene Kreisläufe Leckageraten auf unter 0,1 % pro Jahr senken. Entscheidend sind fachgerechte Installation und Drucktests.

Die Vorlauftemperaturen liegen typischerweise bei 25–35 °C, Rücklauftemperaturen können 45–50 °C erreichen. Diese höheren Temperaturen ermöglichen eine sinnvolle Abwärmenutzung, etwa für Fernwärmenetze oder industrielle Prozesse.

Der Wartungsaufwand steigt im Vergleich zur Luftkühlung. Kühlmittelqualität, Korrosionsschutz und Pumpenredundanz müssen regelmässig überprüft werden. Dennoch hat sich DLC in neuen KI-Rechenzentren in Europa und Nordamerika als Standard etabliert.

Immersionskühlung: Maximale Dichte und thermische Stabilität

Bei der Immersionskühlung werden Server vollständig in eine dielektrische Flüssigkeit getaucht. 2026 unterstützen Einphasen-Systeme Rack-Äquivalente von über 100 kW, Zweiphasen-Lösungen können in spezialisierten Umgebungen 150 kW überschreiten. Die Wärmeverteilung ist besonders gleichmässig, da alle Komponenten direkt von der Flüssigkeit umgeben sind.

Effizienz ist einer der grössten Vorteile. Gut geplante Anlagen erreichen PUE-Werte zwischen 1,05 und 1,15. Da auf Hochgeschwindigkeitslüfter verzichtet wird, lassen sich auf Serverebene 10–15 % elektrische Energie einsparen. Zudem reduziert die gleichmässige Kühlung thermisches Throttling und verbessert die Dauerleistung bei intensiven KI-Workloads.

Die Anfangsinvestitionen sind hoch. Dielektrische Flüssigkeiten sind kostenintensiv, und die Infrastruktur unterscheidet sich deutlich von klassischen Rack-Layouts. Hardware-Kompatibilität muss sorgfältig geprüft werden, auch wenn immer mehr Hersteller entsprechende Unterstützung anbieten.

Praktische Abwägungen bei Immersionssystemen

Das Flüssigkeitsmanagement ist entscheidend für die langfristige Stabilität. Verunreinigungen müssen überwacht und Filterzyklen eingehalten werden. Moderne Fluide sind chemisch stabil, erfordern jedoch klare Betriebsrichtlinien.

Serviceprozesse unterscheiden sich deutlich von herkömmlichen Umgebungen. Beim Herausnehmen eines Servers aus einem Tank sind geeignete Schutzmassnahmen und strukturierte Abläufe erforderlich.

Immersion entfaltet ihr wirtschaftliches Potenzial besonders bei extrem hoher Leistungsdichte und begrenzter Fläche. In Colocation-Umgebungen oder bei Nachrüstprojekten können jedoch bauliche Einschränkungen die Umsetzung erschweren.